Een marathon op de loopband – tja, dat is er een die al lang op mijn lijstje van gekke uitdagingen staat. Ik ken niemand persoonlijk die zoiets heeft gedaan, maar ik ben niet de enige die de uitdaging met vermoeidheid, zowel fysiek als mentaal, aangaat. Er worden zelfs records van bijgehouden.

Gisteren, vrijdag 23 januari 2026, was het zover; er stond, in voorbereiding op de Zestig van Texel, een duurloop van veertig kilometer op het programma en dat ligt natuurlijk wel akelig dicht bij de marathonafstand van 42,195 kilometer. Ik had al eerder, omdat ik soms echt alleen op de loopband kan lopen om de babyfoon in de gaten te kunnen houden, een keer een duurloop van 35 kilometer gedaan op wat sommigen de dreadmill noemen ('For almost as long as I’ve been a runner, I've heard the phrase "Treadmill?! More like dreadmill."), maar eigenlijk beviel me dat, als 'gekkig' experiment welteverstaan, best wel.

_Treadmill_ of _dreadmill_?

Nu dus een marathon, die ik maar bestempelde als 'tempoduurloop', want ik dacht dat het mooi zou zijn de 42,195 kilometer, als ik dit dan toch een keertje doe, binnen de drie uur te lopen. Daarbij komt dat mijn zoontje, op een goede dag, tussen de middag meestal zo'n drie uur slaapt, dus heel veel meer tijd had ik niet. Ik zette alles van tevoren klaar, van de loopband, een tafeltje en een camera tot voldoende eten en drinken op en om de loopband. Dat is wel een voordeel voordeel ten opzichte van een lange training buiten: water kon ik netjes naast de display van de loopband kwijt en ik hoefde geen bananen of ander etenswaar in de zakken van je hardloopbroek te proppen. Vorige week nog, tijdens een mooie trail rond Lage Vuursche, was de banaan in het zakje van mijn broek verworden tot bananenmilkshake.

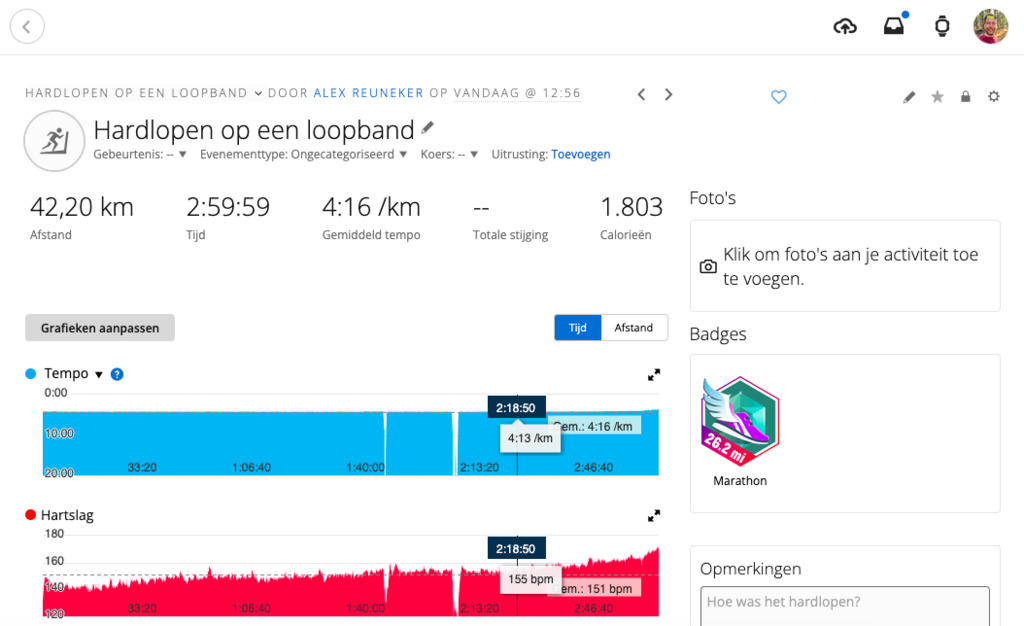

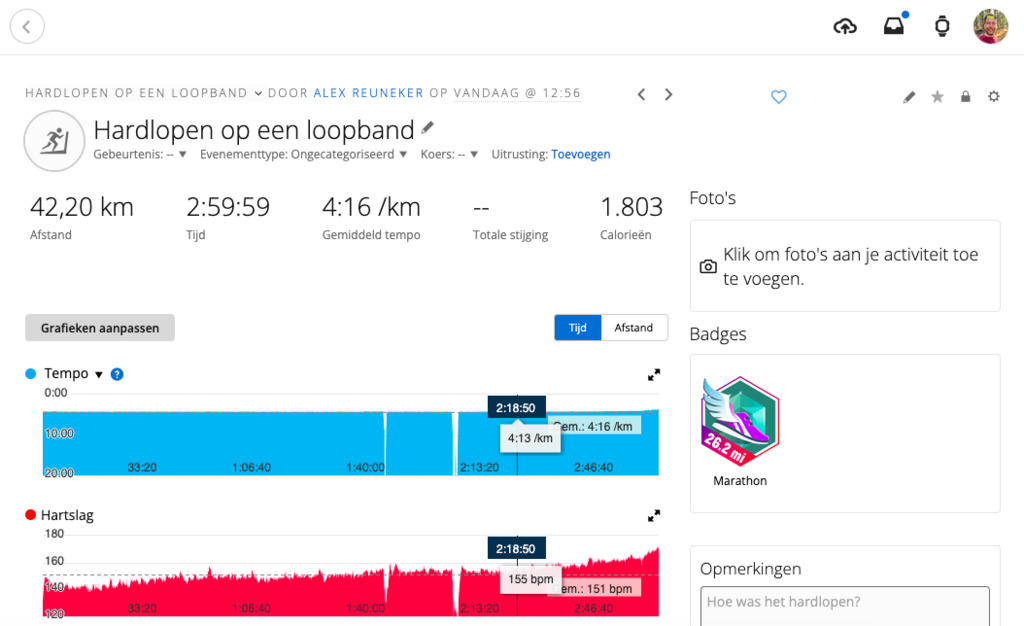

Ik berekende op welk tempo ik de grondig geijkte loopband* moest zetten om met wat marge binnen de 3 uur the 'finishen'. 'Finishen' tussen aanhalingstekens, want van een echte finish, zoals het hoort bij een marathon, was natuurlijk geen sprake. Ik zou een tempo van 4:13 minuten per kilometer lopen (14,23 km/u, maar op de loopband, vanwege zorgvuldig ijken met de Runn-sensor, 15,8/15,9 km/u), inderdaad wel wat sneller dan mijn normale duurlooptempo van circa 4:20-4:30 per kilometer, maar dan zou ik in 2:58 uur klaar zijn.

Zo'n 22 minuten 'onderweg'

Van de twee minuten speling wist ik dat ik zo'n dertig à veertig seconden nodig zou hebben om de loopband na 100 minuten te resetten. Dan is namelijk het maximum van het apparaat bereikt en stopt zowel het display als het draaien van de band. Waar ik echter niet op had gerekend, was dat ik – wellicht door meer drinken 'onderweg' of niet zo'n gedegen voorbereiding qua eten vooraf als bij een echte marathon – rond de 28 kilometer plotseling een toiletbezoek moest plegen. In beide gevallen liep, zoals bij een echte marathon, de tijd gewoon door. Een voordeel was overigens wel dat ik daarna de garagedeur open kon laten, want die zat dicht en de afstandsbediening lag buiten bereik. Lees: geen daglicht, uitzicht op een saaie garagedeur en geen windje of frisse lucht. Overigens had ik wel oortjes klaargelegd, maar ik heb ze pas op zo'n dertig kilometer in gedaan en de podcast Naar de Vaantjes geluisterd. Verder wilde ik zo min mogelijk afleiding – die heb ik tijdens een immers marathon ook niet, al heb je dan, net als bij een lange duurloop, het uitzicht en de omgeving om te bekijken en, in geval van een wedstrijd, publiek.

Er waren, naast de dichte deur, nog wat tegenvallers. Zo had mijn kat in de ochtend iets omgestoten dat precies op mijn kleine teen landde. Dat voelde ik vanaf het begin en daarbij had ik vanaf tien kilometer al last van mijn wedstrijdschoenen; een naar, brandend gevoel aan de onderkant van de buitenzijde. De kleine teen werd gedurende de marathon steeds pijnlijker, tot op het punt dat ik me afvroeg of ik er niet mee moest stoppen. Door die gedachte en misschien doordat ik vanaf 28 kilometer de garagedeur open had staan er er dus ook op de voeten frisse lucht terechtkwam, leek het echter minder te worden, dus ik besloot door te gaan. De kleine teen hield zich daarna goed.

De afgelegde loopbandmarathon in 2:59:59

Door de reset- en toilettijd heb ik de laatste vier kilometer stapsgewijs versneld naar 3:30-3:40 per kilometer, zodat ik, weliswaar op 't nippertje, uiteindelijk 42,20 kilometer liep in 2:59:59. Met wat hobbels toch: missie geslaagd. Ja, het was een gekke uitdaging, maar wel leuk om een keer te doen en de duurloop van 42 kilometer van deze week is volbracht. Nu zal niet iedereen deze uitdaging als 'leuk' bestempelen, maar ik schreef al eerder 'het [voelde aan] als experiment en ook dat laat volgens mij wel zien dat ik behoefte heb aan afwisseling en nieuwe routes, omgevingen of – iets breder – nieuwe of andere ervaringen.' Vandaag, de dag erna, voel ik me best goed. Ik heb geen last van de voeten en geen gekke spierpijn – een loopband loopt toch anders dan op de weg – maar wel vermoeid. Niet vreemd, uiteraard. Ik merkte dat vooral tijdens een uurtje rustig uittrappen op de racefiets en dan vooral in de bovenbenen. Het ritje ging gelukkig echt lekker rustig en voelde precies goed op dat moment. De rest van de dag doe ik het lekker rustig aan, met een boodschappenwandelingetje met mijn zoontje en verder lekker helemaal niets.

Na afloop

* Totaal op loopband: 24,68km (100 min.)+19,63km (78:15 min.)=44,31km. Ik stelde de loopband in op 14,8 km/u, daarna een stuk 14,9 km/u, toen weer 14,8 km/u en de laatste vier kilometer geleidelijk versneld naar 3:30-3:40 per kilometer. Ik heb tijdens het ijken wat marge ingebouwd, zodat de Garmin, die een Runn-sensor uitleest, nooit te optimistisch is, maar je altijd ongeveer een procent meer loopt dan aangegeven. Wil je zelf je loopband ijken? Check dan de Treadmill Calibration Tool die ik in 2024 maakte en die gratis online te gebruiken is. Zie ook deze post uit datzelfde jaar.